Remerciements

Je remercie l'équipe archéologique du chantier de Boves.

Je remercie Laurent Nottale, Marie-Noëlle Célerier, Thierry Lehner et Amaury de Kertanguy pour leur accueil à l'Observatoire de Meudon en juin-juillet 2006 et pour tout ce qu'ils ont pu m'apprendre.

Je remercie Philippe Martin pour sa grande patience et disponibilité, sans lui ce mémoire ne serait pas ce qu'il est.

Je remercie l'UMR espace – Avignon de m'avoir si bien accueilli durant cette année universitaire 2006-2007.

1. Avant-propos

J'ai entendu parler pour la première fois de la théorie de la relativité d'échelle (Nottale, 1993, 1998) lors d'un cours de Philippe Martin en décembre 2003 à l'Université d'Artois. Qui aurait pu me dire à cette date que trois ans plus tard j'écrirai un mémoire complètement tourné vers cette théorie. Ecrire de la géographie à partir de la relativité d'échelle peut être vu comme une gageure. En effet, il s'agit d'une théorie physique, écrite en langage de physicien et pour les physiciens, ou à la rigueur pour les mathématiciens. Nous sommes donc loin du corpus géographique à l'exception de deux choses : les échelles et les formes. Je n'ai pas la prétention d'avoir tout compris de cette théorie tant elle est riche et tant ses concepts et ses idées sont profondes. Cependant, il m'est possible d'en présenter les fondements et les applications spatio-temporelles, et de montrer qu'elle a toujours été présente en filigrane en géographie, de manière informelle, et cela depuis l'émergence de l'école vidalienne !

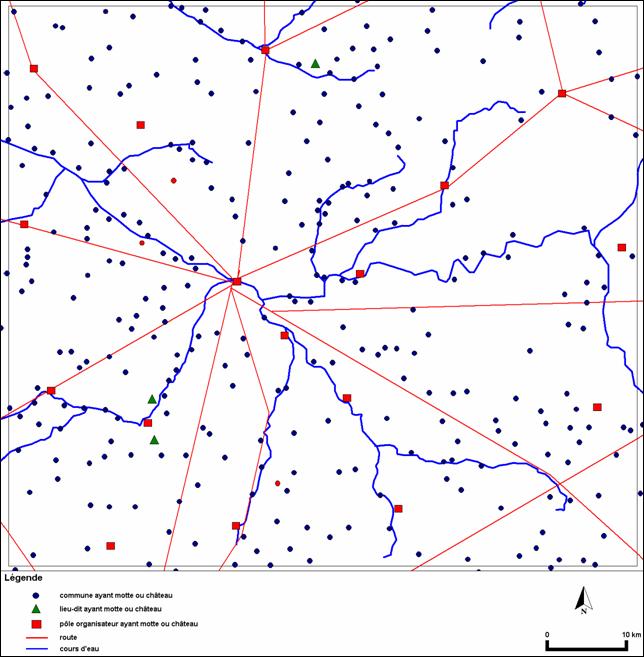

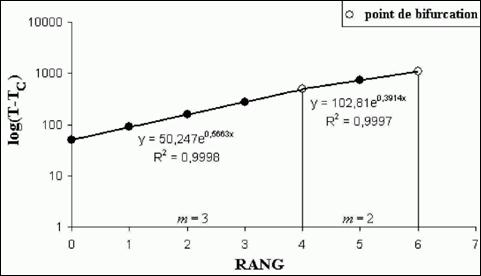

J'avais déjà commencé cette entreprise dans mon mémoire de master 1 (Forriez, 2005). Au cours de mon premier stage archéologique à Boves (été 2004), je m'étais aperçu que la chronologique relative du château obéissait à un ordre log-périodique. Aussi, j'avais décidé de bâtir une réflexion épistémologique autour de ce constat dans ce mémoire de master 1. Elle m'a amené à commencer une double analyse : d'une part une analyse temporelle sur le site de Boves et d'autre part une analyse spatiale de la localisation des autres sites en Picardie historique (Pas-de-Calais, Somme, une partie de l'Aisne et Oise). Ces analyses ont eu deux défauts majeurs. D'abord, l'analyse temporelle n'a été réalisée que sur le château de Boves. De plus, l'analyse spatiale commencée est lacunaire et peu convaincante car elle n'a été faite que sur la carte du XXIe siècle des mottes et châteaux, carte qui était d'ailleurs incomplète. Aujourd'hui, cette carte a été remise à jour ce qui permet de préciser l'analyse. Il faudra ainsi croiser les deux pour obtenir une véritable analyse spatio-temporelle. Elle consistera à partir de l'état initial arbitrairement choisi de la répartition des mottes à l'an 1000, par exemple, et à lancer un petit programme de diffusion spatiale à partir de l'équation de Schrödinger généralisée pour voir comment la structure spatiale de la constellation des châteaux évolue, donc voir si le déploiement théorique est conforme aux données connues.

nbsp; Après mon mémoire de master 1, j'ai décidé d'occuper mon temps libre à faire avancer mon travail de recherche entrepris en 2004-2005. Il s'agit d'en achever la partie technique afin de pouvoir réaliser une simulation spatiale autrement que par les méthodes devenues classiques d'automates cellulaires ou de systèmes multi-agents. Cet objectif a été encouragé par ma rencontre avec Laurent Nottale en janvier 2006. J'avais des doutes qu'en tant à ma maîtrise de l'outil mathématique et à la validité de ce que j'avais entrevu. Finalement, il s'est avéré que j'avais envisagé par intuition une voie fructueuse.

Aussi, pour me donner les moyens de cette recherche, j'ai décidé de faire un stage avec Laurent Nottale en juin-juillet 2006 à l'Observatoire de Meudon. Ce fut un grand moment pour moi. J'ai vu comment fonctionne la recherche française et ce qu'est réellement le métier de chercheur. J'ai ainsi décidé de poursuivre dans ce mémoire de master 2 cette recherche passionnante sur la relativité d'échelle et sur son utilité et de son application en analyse spatiale, et plus généralement en géographie.

Dans ce travail, je veux simplement essayer d'établir un recueil suffisamment approfondi sur un corpus de méthodes dispersées dans plus de 300 ouvrages (si on se limite à la bibliographie française) ! Ainsi, une très importante synthèse sur le devenir, sur les théories, sur les concepts et sur l'application des sciences a été entreprise, et ce, pour satisfaire à deux objectifs : (1) montrer que la science, au sens général, vit vraisemblablement un moment crucial de son évolution ; (2) introduire l'ensemble des outils à la disposition des archéologues, des géographes, et peut être des historiens afin qu'ils puissent analyser plus en profondeur leurs résultats dans le cadre d'un espace-temps, et perfectionner les méthodes qu'ils utilisent.

Pour conclure, je tiens à préciser que ma formation d'historien m'incite plus facilement à prendre des exemples dans des espaces historiques, donnant ainsi en plus de la dimension spatiale, une dimension temporelle non négligeable, comme c'est le cas dans l'application de Boves. Toutefois, d'autres exemples seront développés. Cela étant, cet opus est purement épistémologique et technique. Il présente peu d'exemples et de cas concrets, ceux-ci étant réservés pour ma thèse.

2. Introduction générale

L'analyse spatiale a déjà une cinquantaine d'années. Elle a su faire progresser la géographie vers une science quantitative. Cependant, il faut reconnaître qu'elle manque toujours d'une certaine cohérence. De nombreux géographes ont testé un faisceau de méthodes quantitatives différentes sur l'espace géographique, et ils ont réussi, par ce biais, à analyser ce dernier. Toutefois, ces méthodes et outils allant de la mécanique quantique à la mécanique newtonienne, en passant par des analyses statistiques comme les analyses en composantes principales ou les analyses factorielles de correspondance, n'offrent pas la possibilité de démarquer clairement la géographie des autres disciplines. En effet, d'une part, ces méthodes ont « marché », mais on ignore pourquoi. L'exemple type renvoie bien sûr aux automates cellulaires ou aux systèmes multi-agents. D'autre part, elles appartiennent à des théories non géographiques, en soi, et qui le restent, même si elles ont fait leur preuve en géographie. Ce mémoire a pour objectif de proposer une tentative de clarification sur la causalité profonde de l'organisation spatiale de l'interface terrestre (formes naturelles, formes anthropiques aux échelles moyennes) dont la géographie à la charge de l'étude. Il entre donc dans le projet de l'étude des formes en géographie comme élément structurant de la discipline, à la lumière des théories transdisciplinaires de la morphogenèse développées depuis les années 1980.

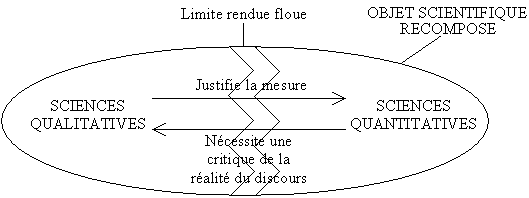

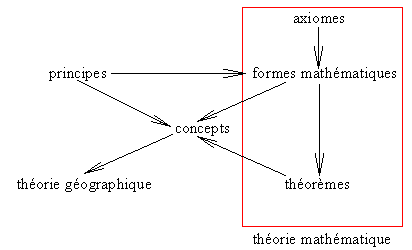

Le problème levé semble si important qu'il tend à recouvrir, à lui seul, toutes les autres connaissances. Dans cet effort de conciliation, il faut distinguer synthèse, fusion et recomposition. Il ne s'agit ici ni de faire une synthèse, ni d'effectuer une fusion des connaissances acquises autour de l'immense thématique qu'est la complexité. Il s'agit de réaliser une recomposition des échanges entre les différentes disciplines pour construire des objets scientifiques communs (fig. 1).

La relativité d'échelle est une extension à partir de principes premiers de la géométrie fractale. Elle a déjà permis de nombreuses applications dans différents domaines (physique, biologique, économique, etc.). De ce fait, la compréhension de l'espace terrestre à la lumière de la relativité d'échelle pourrait donner une force conceptuelle supplémentaire à tous les travaux géographiques antérieurs, et particulièrement ceux de l'analyse spatiale. Cependant, ce mémoire ne doit pas être pris comme une rupture, mais comme un complément théorique qui m'apparaît indispensable pour mieux fonder la géographie en tant que science autonome et originale.

Les essais antérieurs de Roger Brunet ou de Bernard Claval par exemple, ont toujours été problématiques dans la mesure où, pour considérer une localisation dans l'espace géographique, il fallait systématiquement faire appel ou renvoyer aux connaissances des autres sciences telles que l'économie, l'histoire, la sociologie, l'ethnologie, le droit, la géologie, la biologie, la physique, la chimie, les mathématiques pour ne citer qu'elles. Au final, la géographie spatiale est un melting pot de sciences, faisant de la géographie une discipline « carrefour ». La géographie se trouve donc être une science de synthèse, à la croisée de ce que d'autres sciences ont développé sur la localisation dans l'espace ! C'est le problème de la causalité interne et externe qu'a défini Philippe Martin (2004a). Le dualisme est le suivant : la dimension spatiale est-elle structurelle et causale, ou est-elle une conséquence attendue de la dynamique économique, sociologique, politique, ethnologique, etc. ? Dans le premier cas, le champ de la géographie peut lui être propre et est original ; alors que dans l'autre, la géographie n'est qu'une synthèse ou un « carrefour » d'autres discours, et dans ce cas une individuation ne peut être envisagée qu'au niveau des conséquences des règles et fonctionnements des métathéories dont la géographie dépendrait ; ce qui est peu.

En conséquence, tout se résume presque à savoir comment on peut objectiver les formes en géographie. Quelques éléments seront envisagés dans ce mémoire pour répondre à cette question. Il faut rappeler qu'une série de tests a permis d'expérimenter la pertinence de l'utilisation de la relativité d'échelle comme outil théorique de base pour fonder la géographie en tant que science des formes. Les quelques résultats obtenus sont plutôt convaincants (Forriez, 2005 ; Forriez, Martin 2006), même s'ils restent largement prospectifs.

Ainsi, une réflexion en quatre parties peut être proposée pour traiter cette vaste question. La première partie fera le point sur ce que sont les sciences de la complexité et sur la place que la géographie tient, ou plutôt devrait y tenir. La seconde partie fera une mise au point sur le concept d'échelle en géographie. La troisième partie présentera rapidement la théorie fractale et la relativité d'échelle. La quatrième partie développera au final quelques applications de ces théories de la complexité en géographie.

3. Géographie et complexité

Les géographes se sont intéressés relativement tôt à la complexité (Pumain et alii, 1989 ; Frankhauser, 1994 ; Dauphiné, 1995), mais tous ont vraisemblablement rencontré une difficulté : l'immense complexité de la formalisation mathématique qui n'appartient que peu à leur culture dont on sait qu'elle est encore largement littéraire. Aussi, se sont-ils contentés de fonder une série de réflexions épistémologiques pour guider la communauté des géographes sur cette voie. Malheureusement, elles n'ont fait guère école. La diffusion de ces concepts reste très restreinte car il faut bien l'avouer, ils sont très difficiles à comprendre. Cette partie a deux objectifs. D'une part, elle cherche à repositionner le débat de la complexité dans son contexte historique et à redonner des définitions plus ou moins précises autour de ce thème. D'autre part, cette partie essayera de lancer quelques pistes pour réinsérer la complexité au cœur du débat géographique contemporain.

Pour ce faire, il faudra commencer pour redéfinir ce qu'est l'épistémologie et à quoi elle sert. Puis, à partir de ces définitions, il s'agira de définir les principaux cadres doctrinaux qui ont alimenté le débat au sein de l'école géographique française. Et enfin, il faudra rappeler quelques définitions et repositionner la thématique de la complexité au sein des sciences, et particulièrement de la géographie française.

3.1. Eléments d'épistémologie

3.1.1. Philosophie, science et sciences

« A l'origine, philosophie et science étaient confondues. La connaissance, la réflexion sur la démarche scientifique en général, ou sur les progrès de chacune des sciences, relevaient du domaine des philosophies. La séparation du domaine scientifique devait amener un glissement de la signification des termes, qui aboutit aujourd'hui à une confusion regrettable » (Grawitz, 2001, p. 7).

La philosophie englobe toutes les sciences particulières qui ne sont qu'une portion limitée de la réalité. Les sciences particulières partent de présuppositions. La méthode et l'objet de la philosophie ne sont pas fixés par avance, mais elles les déterminent à chaque fois de nouveau. Emmanuel Kant a proposé de regrouper la philosophie en quatre thèmes. Que puis-je faire ? (Métaphysique) Que dois-je faire ? (Morale) Que m'est-il permis d'espérer ? (Religieux) Qu'est-ce que l'homme ? (Anthropologie)

L'épistémologie est « l'étude critique des principes, des hypothèses et des résultats des diverses sciences, destinée à déterminer leur origine logique, leur valeur et leur portée objective » (Lalande, in Grawitz, 2001, p. 8)l'origine, il s'agit d'une discipline philosophique. L'épistémologie est la synthèse de la gnoséologie (ou théorie de la connaissance) et de la philosophie des sciences. Elle étudie les connaissances, surtout dans une optique de comprendre les processus menant à la connaissance d'une science, prise ici dans le sens de savoirs. Après Gaston Bachelard qui fut le dernier philosophe à avoir eu une connaissance totale des sciences, l'épistémologie est entrée, plus ou moins, dans les différentes disciplines. La géographie semble être la science qui a le plus développée cette approche car le géographe sait que les apparences sont souvent trompeuses. Cela étant, il existe plusieurs définitions servant de socle commun.

La science offre des définitions multiples et variées mais aucune d'entre elles n'est satisfaisante. La science est « l'usage de démontrer ce que l'on affirme, c'est-à-dire de déduire des principes certains et immuables par voie de conséquences légitimes » (Wolff, in Grawitz, 2001, p. 22). Cette définition met fin au surnaturel dans les sciences. En effet, la science « est la connaissance méthodique dont le contenu, d'une manière contraignante est à la fois certain et universellement valable » (Jaspers, in Grawitz, 2001, p. 23). Cependant, il est clair que la science désigne un ensemble de connaissances plus ou moins universelles et plus ou moins vérifiables, obtenues grâce à un savoir-faire qui sont établies par l'intermédiaire d'un discours se décomposant en trois champs : le champ phénoménal, le champ théorique et le champ ontologique. Seuls le champ phénoménal et le champ ontologique sont clairement définis. Le champ théorique apparaît bizarrement comme un champ « fourre-tout » : c'est ce qui n'est ni phénoménal ni ontologique. Enfin, il faut remarquer que la science est une variable historique, ce qui signifie que l'on peut accepter plusieurs définitions par rapport à ses strates. Ici, il s'agit de développer bien évidemment la définition la plus récente possible.>

Cependant, il faut distinguer la science des sciences. La science renvoie à la théorie de la connaissance c'est-à-dire à la totalité de ce que l'on peut connaître, alors que les sciences renvoient à l'idée d'un découpage dans cette connaissance. À travers les siècles, il y eut de multiples découpages de la science. Le découpage du Moyen Age, par exemple, ne distingue que sept disciplines dont quatre majeures et trois mineures. Aujourd'hui, le découpage date du XIXe siècle. Il s'est affirmé au début du XXe siècle avec le développement du réductionnisme. Ainsi, les sciences se sont multipliées. Le savoir se décline désormais en disciplines académiques et en sous-disciplines. En ce début du XXIe siècle, le découpage est devenu si fin que l'on ne sait plus vraiment à quelle grande discipline appartient telle sous-discipline, ou bien on ne comprend pas pourquoi dans telle science on trouve telle sous-discipline, alors qu'on pourrait la ranger dans la science voisine !

De plus, la distinction entre sciences et humanités est récente dans l'histoire de la pensée occidentale. Au début du XVIIe siècle, les « lettres » désignent tout le domaine de la connaissance. La rupture est consacrée, en France par exemple, par la création en 1852 du Baccalauréat ès-sciences. Toutefois, la pensée qui va définitivement séparer sciences et humanités, c'est le marxisme. Les penseurs marxistes opposent les sciences quantitatives et les sciences qualitatives, le postulat étant que les premières seraient plus scientifiques que les secondes, donc plus utiles. Le développement de la pensée utilitariste tout au long du XXe siècle, dont la consécration est la société de consommation, aboutit à une sorte de « blocage psychologique » qui maintient fortement cette distinction. La comparaison entre le budget d'une faculté de mathématique et une faculté de géographie en France illustre bien ce propos. Toutefois, l'idéologie communiste est tombée en 1991. De ce fait, cette distinction peut-elle toujours se maintenir en ce XXIe siècle ? Par ailleurs, la notion d'utilité est ambiguë dans la mesure où il existe bien sûr une utilité immédiate liée à la matérialité du monde, à la production de produits, à l'échange mais il y a aussi une utilité différée et moins visible liée par exemple aux cadres de pensée qui permettent le fonctionnement des sociétés de consommation en particulier. Que l'on songe par exemple à un certain nombre de règles traditionnelles liées au statut de l'enfant et de la femme…

La pensée marxiste a consacré une division de la connaissance en deux sciences : les sciences « dures » et les sciences « molles » - ces dernières n'atteignant jamais le même niveau de scientificité que les premières - ou plus exactement la division entre les sciences utiles et les sciences inutiles. Cette fracture a été accentuée, pour ne pas dire consommée, par la Guerre froide. Pourquoi cette division ? C'est d'abord pour satisfaire le besoin utilitariste de la pensée libérale occidentale, repris avec véhémence (et de façon apparemment paradoxale) par la pensée marxiste. Cette division semble avoir disparu avec la chute de l'Union des Républiques socialistes soviétiques ! Certains, comme Stephen Jay Gould (2005), prétendent que la séparation n'a jamais existé.

Cependant, Stephen Jay Gould (2005) déplore cette distinction. Il qualifie les sciences de « renard » et les humanités1 de « hérisson ». Le renard est rusé, l'hérisson est tenace. Stephen Jay Gould (2005) démontre que le conflit entre les sciences et les humanités est un « pseudo-conflit » (p. 31). En effet, les termes « sciences » et « humanités » ne peuvent être employées pour désigner des entités suffisamment stables, engagées dans une lutte raisonnablement continue entre des positions intellectuelles durables et bien affirmées » (Gould, 2005, p. 92). La dichotomie est trop simpliste. « Le concept même d'opposition entre science et humanité n'est qu'une négation absurde de nos capacités mentales et notre complexité – piège non moins néfaste aux potentialités humaines que nos dérisoires efforts passés pour maintenir séparées et inégales des races qui n'existent pas » (Gould, 2005, p. 121). De plus, Stephen Jay Gould insiste sur le danger du « chiffre 2 » pour le raisonnement. Il dénonce « notre déplorable tendance à réduire toute situation complexe à une dichotomie conflictuelle » (Gould, 2005, p. 120). Il faudrait, selon lui, développer des raisonnements ternaires réduisant cette dichotomie.

Quoi qu'il en soit, l'ambiguïté du terme science demeure. Au sens étroit, il ne concerne que « l'ensemble de connaissances établi de façon systématique, à référence universelle et susceptible d'être vérifiée » (Grawitz, 2001, p. 25) c'est-à-dire les sciences physiques et naturelles. Au sens large, si on reprend la définition de Karl Jaspers, le terme désigne également les humanités. « C'est le souci de rigueur, non l'utilisation abusive de termes scientifiques, qui permettra aux sciences humaines d'accéder au statut de science » (Grawitz, 2001, p.8). Il semblerait que les sciences de l'homme seraient une réponse à la crise provoquée par les découvertes militaires et les dégâts écologiques des sciences au sens étroit. Les sciences de l'homme cherchent à comprendre le passé, et à partir de là, essayer de prédire l'avenir. Claude Lévi-Strauss (1908- ?) précise que sciences humaines et sciences sociales sont synonymes. De ce fait, on peut supposer que sciences de l'homme englobent les sciences humaines et sociales. Jean Piaget (1896-1980) propose une distinction intéressante : les sciences « nomothétiques » qui cherchent à dégager des lois ou des relations quantitatives (la psychologie scientifique, la sociologie, l'ethnologie, la linguistique, l'économie, la démographie…). Toutes ces sciences utilisent soit des méthodes d'expérimentation directe, soit d'expérimentation au sens large d'observation systématique. Les sciences historiques reconstituent le déroulement de la vie sociale au cours des temps. Les sciences juridiques et philosophiques constituent les deux dernières catégories de Jean Piaget. Il est important de constater que les sciences sociales ne sont pas encore arrivées à construire une théorie de l'Homme, leur permettant d'intégrer l'ensemble des phénomènes observés.

Enfin, la science est une croyance. De ce fait, une science a besoin d'un projet disciplinaire tel que l'avait défini Gaston Bachelard (1934). Ce projet la caractérise et la différencie des autres. « Au-dessus du sujet, au-delà de l'objet immédiat, la science moderne se fonde sur le projet. Dans la pensée scientifique, la méditation de l'objet par le sujet prend toujours la forme du projet » (Bachelard, 1934, p. 15). En effet, les différentes sciences se partagent les objets d'étude qui sont les fondements de la manière de penser la science, c'est-à-dire un moyen matériel de développer une hypothèse de recherche. L'hypothèse est une proposition de réponse à la question posée qu'il faut vérifier, tester. La définition de l'objet d'étude doit entrer dans le projet scientifique de la science envisagée. Dans nos civilisations occidentales, la définition d'objet d'étude repose essentiellement sur les quatre causes d'Aristote : la cause matérielle, l'objet existe, la cause efficiente, l'objet est issu d'une dynamique, la cause finale, l'objet a un but à atteindre et la cause formelle, cet objet est perçu par exemple. Pour René Thom, le but de la science est de « réduire l'arbitraire de la description » lié à la perception (1974, p. 276-277).

Toujours dans le domaine de la croyance, on peut noter que « […] le phénomène le plus intéressant c'est qu'aujourd'hui la science joue le rôle tenu dans le passé par la religion, en ce sens la science est aujourd'hui porteuse des espérances eschatologiques de l'humanité » (Thom, 1983, p. 16). « Nos sociétés se tournent vers les scientifiques comme les anciens se tournaient vers les oracles pour avoir des avis sur leurs inquiétudes… quelquefois soulevées par les scientifiques eux-mêmes » (Sapoval, 1997, p. 19). « L'expertise scientifique est la demande, faite à des « savants », de fournir des réponses techniques de société, réponses dont le contenu peut influencer des décisions politiques, juridiques ou même éthiques » (Sapoval, 1997, p. 19). Toutefois, une expertise n'est pas une recherche car elle se fait dans l'urgence à partir des théories que l'on croit être justes. Le problème de la croyance scientifique est pourtant sensiblement différent de celui de la croyance religieuse. En fait, il s'agit d'une croyance issue de méthodes d'analyse différentes évoluant au cours du temps, tandis que les croyances religieuses sont basées sur une différence de dogmes, posés à l'origine de cette religion. Pourtant, il existerait une guerre entre la science et la religion. Pour Stephen Jay Gould (2005), le conflit entre science et religion ne se serait jamais posé ! « La « religion », en tant qu'entité cohérente, ne s'est jamais opposée à la « science », que ce soit sur des idées générales ou sur des points de détail » (Gould, 2005, p. 41). La dichotomie science/religion est un mythe, car les pouvoirs laïques ont parfois su se montrer plus intolérants que les religions. Cependant, le relativisme du postmodernisme est néfaste car il alimente la pseudo – « guerre des sciences ».

Albert Einstein avait pourtant mis en garde l'humanité : « prenez garde à ne pas faire un dieu de votre intelligence ; elle a… des muscles puissants, mais aucune personnalité » (in Stewart, 1997, couverture). Les marxistes auraient, sans doute, souhaité faire des sciences « dures » une nouvelle religion, qui ne laissait aucune place à l'incertitude. La croyance ne fait pas partie de la science, mais depuis une trentaine d'années, la croyance a ressurgi dans les sciences : on a cru au chaos, ou on n'y a pas cru. Le problème, c'est que même en démontrant que le chaos existe, nombreux sont ceux qui répondent : « je suis convaincu par votre démonstration, je la respecte, mais je n'y crois pas ». Le verbe « croire » est choquant. La frontière entre science et religion serait-elle plus floue que ce que la raison admet ! Une démonstration est soit vraie, soit fausse, et pas partiellement vraie ou partiellement fausse. Aucune croyance ne doit s'y immiscer quelle soit laïque ou religieuse dans les sciences. Pourtant, et c'est un sentiment humain, on a besoin de croire en quelque chose, en un idéal, mais cette croyance a-t-elle sa place dans la science ? Certainement pas, et ce qu'elle soit « dure » ou « molle », seule la froideur des faits compte, qu'on le déplore ou non. C'est ainsi qu'aux yeux des théories économiques de l'innovation ou de la productivité, la science doit être finalisée. Cependant, tous les domaines scientifiques ne peuvent pas être finalisés. C'est le cas de la morphogenèse qui va particulièrement nous intéresser. Peut-on prétendre à l'inutilité de cette recherche ? Un paradoxe se crée puisqu'une recherche ne peut devenir utile uniquement lorsque l'on a pu mener cette recherche. La crise relative des sciences modernes s'inscrit dans la crise économique débutée en 1973. Par conséquent, une recherche doit aujourd'hui être finalisée, sinon elle ne trouvera pas de financement. Cependant, certaines recherches sont difficilement définissables, mais importantes pour l'avenir de l'humanité. C'est un cercle vicieux connu qui empêche l'innovation scientifique dans les domaines fondamentaux.

Par ailleurs, les sciences modernes (fig. 2) distinguent les sciences empiriques qui décrivent, explorent, expliquent, prévoient à partir de l'expérience scientifique ou humaine et les sciences rationalistes qui sont marquées par une logique interne exceptionnelle.

SCIENCES EMPIRIQUES | SCIENCES RATIONALISTES | |

|---|---|---|

Sciences de la nature | Sciences de l'homme | |

Physique | Sociologie | Mathématiques |

Psychologie | ||

3.1.2.1. Les phénomènes

Les phénomènes sont des occurrences spatio-temporelles qui affectent un observateur par ses sens. Elles sont étudiées par ce que l'on appelle la phénoménologie. Cependant, la phénoménologie n'a rien de scientifique : c'est une doctrine philosophique. Elle a été développée au début du XXe siècle par Edmond Husserl (1859-1938). Elle est née d'une contestation du kantisme et de la psychologie de l'école de Warzbourg. Elle est hostile à l'idéalisme et à l'empirisme, lié au développement scientifique et industriel. « Même les matériaux recueillis dans l'observation empirique sont construits, au lieu d'être simplement vécus. La phénoménologie se veut une méthode de retour aux choses elles-mêmes, dans les descriptions, en dehors de toute conceptualisation. Il s'agit d'une « eidétique » ou « science des essences » qui repose avant tout sur l'intuition. Comment se situe l'individu par rapport à cet objet vécu ? » (Grawitz, 2001, p. 11).

La phénoménologie est à l'origine des diverses théories existentialistes. Elle insiste sur la supériorité du vécu, du subjectif sur les constructions conceptuelles du champ théorique. « Toute science est avant tout l'étude d'une phénoménologie » (Thom, 1983, p. 5). La source d'une science est bien une phénoménologie, mais le but de la science est de chercher à la dépasser. Aussi, les problèmes de la connaissance sont étroitement liés aux différentes positions philosophiques.

3.1.2.2. La méthode et les techniques

Il ne faut pas confondre la méthode et les techniques. Pour faire simple, la méthode est un ensemble de techniques, et la technique sans méthode ne suffit pas. Méthode et techniques ne valent rien si on ne se pose pas les bonnes questions.

3.1.2.2.1. La méthode

« Le propre de la méthode est d'aider à comprendre au sens le plus large, non les résultats de la recherche scientifique, mais le processus de recherche lui-même » (Kaplan, in Grawitz, 2001, p. 15). La méthode est l'ensemble des techniques permettant d'une part l'objectivation des phénomènes observés et d'autre part de les transformer en faits avérés. C'est une notion ambiguë. « Jean Piaget (1967) remarque qu'elle n'est pas une branche indépendante, car les problèmes d'épistémologie et de logique posent constamment des questions de méthode » (Grawitz, 2001, p. 15). On peut toutefois distinguer quatre types de méthodes.

(1) La méthode au sens philosophique est constituée de l'ensemble des opérations intellectuelles par lesquelles une discipline cherche à atteindre les vérités qu'elle poursuit, les démontre, les vérifie. Cette conception de la méthode dans le sens général de procédure logique, inhérente à toute démarche scientifique, permet de la considérer comme un ensemble de règles indépendantes de toute recherche et contenu particulier, visant surtout des processus et formes de raisonnement et de perception, rendant accessible la réalité à saisir.

(2) La méthode comme étant une attitude concrète vis-à-vis de l'objet dicte des façons concrètes d'envisager ou d'organiser la recherche, mais ceci de façon plus ou moins impérative, plus ou moins précise, complète et systématisée. Toutes les méthodes n'influencent pas de la même manière, les mêmes étapes de la recherche.

(3) La méthode liée à une tentative d'explication se rattache plus ou moins à une position philosophique. Elle peut influence telle ou telle étape de la recherche. Ces méthodes visent avant tout un schéma explicatif, qui peut être plus ou moins étendu et se situer à un niveau de profondeur très différent.

(4) La méthode liée à un domaine particulier comporte une manière de procéder qui est propre à un domaine donné comme la méthode historique. Dans ce cas, la méthode se confond avec la théorie, or la théorie définit plutôt le « quoi ? » alors que la méthode devrait définir plutôt le « comment ? ».

3.1.2.2.2. Les techniques

Toute recherche ou application de caractère scientifique doit comporter l'utilisation de procédés opératoires rigoureux, bien définis, transmissibles, susceptibles d'être appliqués à nouveau dans les mêmes conditions, adaptés au genre de problèmes et de phénomènes en cause : ce sont là des techniques. Le choix de ces techniques dépend de l'objectif poursuivi, lequel est lié lui-même à la méthode de travail, qui est à l'origine de la confusion des termes technique et méthode. La technique est une réponse à un « comment ». C'est un moyen d'atteindre un but, mais qui se situe au niveau des faits ou des étapes pratiques. La technique représente les étapes d'opérations limitées, liées à des éléments pratiques, concrets, adaptés à un but défini, alors que la méthode est une conception intellectuelle, coordonnant un ensemble d'opérations, en général plusieurs techniques. Les techniques ne sont que des outils, mis à la disposition de la recherche et organisés par la méthode dans ce but.

3.1.2.3. Les faits

« L'observation scientifique [des phénomènes] est toujours une observation polémique » (Bachelard, 1934, p. 16). En effet, celle-ci entraîne une hiérarchisation des phénomènes qui est ensuite objectivées par une méthode, c'est dire que l'on reconstruit le réel pour obtenir un fait ! Les faits sont donc des constructions obtenues par une méthode d'objectivation scientifique.

3.1.3. Le champ théorique

C'est la mise en relation des faits entre eux, c'est-à-dire la recherche des causes qui les ont produits. Sa construction se fait en deux étapes. D'abord, on établit des principes premiers par différentes observations expérimentales. Puis, on définit des concepts, des modèles, le tout formant une théorie.

3.1.3.1. Les principes premiers

Le champ théorique a besoin de principes dits premiers, c'est-à-dire de principes que le chercheur est obligé de poser et d'admettre sans avoir à les démontrer. Cela montre que le champ théorique n'est jamais premier : il est toujours précédé du champ phénoménal à partir duquel ces principes premiers ont pu être posés. Ces principes sont d'abord littéraires, puis peuvent être exprimés de manière mathématique. Toutefois, il ne faut pas confondre principes et axiomes. En effet, rechercher des axiomes en géographie n'aurait aucun sens car il s'agit d'un terme réservé aux mathématiques. En effet, « les axiomes sont des faits mathématiques considérés comme évidents et que nous ne tentons pas de déduire de principes plus simples » (Chaitin, 2006, p. 70-76). Ensuite, une série de règles générales qui fonctionnent universellement, est démontrée à partir de ces principes premiers. En mathématique, on les appelle théorème, en informatique, résultat, dans les autres disciplines, théorie, tout simplement. La recherche de ces règles correspond à un double objectif : la prédiction ou la rétroprédiction, ainsi que la compréhension. Autrement dit, l'impression de maîtriser les phénomènes que l'on a pu, que l'on peut ou que l'on pourra observer.

Cependant, les axiomes peuvent être réfutés. C'est le cas, par exemple, du cinquième axiome d'Euclide. « Un des grands succès mathématiques du XIXe siècle fut la découverte de la géométrie hyperbolique. Il s'agit d'une géométrie où l'axiome des parallèles est faux. Les axiomes restant de la géométrie euclidienne permettent de démontrer que, étant donné une droite et un point en dehors de celle-ci, il existe au moins une parallèle à la droite passant par le point (la perpendiculaire à la perpendiculaire). L'axiome des parallèles stipule qu'il existe une seule parallèle ; sa négation consiste donc à supposer qu'il en existe plus d'une » (Odifreddi, 2004, p. 46). Le XXIe siècle sera celui de la géométrie fractale. D'autres axiomes peuvent être partiellement réfutés dans certain cas bien précis. C'est le cas du principe de continuité dans le cadre du chaos ou des fractales. « L'hypothèse du continu est indépendante de la théorie des ensembles : elle ne peut être ni prouvée ni […] réfutée » (Odifreddi, 2004, p. 64).

3.1.3.2. La problématique, les raisonnements et les logiques

« Le raisonnement, base de connaissance implique […], une certaine relation entre un sujet et un objet. » (Grawitz, 2001, p. 3) Le sujet englobe l'objet. Le sujet est un thème c'est-à-dire une généralité. Quant à l'objet, il s'agit d'un concept c'est-à-dire une définition d'un mot particulier. Le raisonnement est le lien entre le sujet et l'objet. Cette présentation de la distinction fondamentale est appelée la division platonicienne. Elle pose deux problèmes : comment différencier l'objet, le sujet et le raisonnement ? Quelle est la validité de la logique ?

3.1.3.2.1. La logique

Aristote (384-322 a.-C.) ne s'occupe pas de savoir si le raisonnement est vrai ou faux : s'il est logique, il est valable. C'est la logique formelle. Elle est indépendante du contenu c'est-à-dire de toute affirmation concrète. La logique formelle pose en d'autres termes le problème de la relation complexe entre la vérité et la réalité. « En éliminant le contenu objectif, historique, pratique et social de la connaissance, la logique formelle se transforme en pensée formaliste » (Grawitz, 2001, p.4). Toutefois, la logique soulève deux difficultés : le rejet du langage ordinaire comme support de la logique et le rejet du raisonnement commun des êtres humains.

Aristote fonde la logique. Cependant, ce sont George Boole, Augustus de Morgan et Gottlob Frege qui ont fondé l'alliance entre la logique et les mathématiques. Ainsi, aujourd'hui, la logique se décompose en trois composantes : les mathématiques pour le calcul, la philosophie pour la croyance et la recherche de la vérité et l'informatique pour la simulation, au sens de la théorie des processus de calcul.

On peut résumer la logique en quatre opérateurs (fig. 3).

| La négation | Non |

| La conjonction | Et |

| La disjonction | Ou |

| L'implication ou le conditionnel | Si… alors |

« Si… alors » est une vérité conditionnelle. « Si » est appelé l'antécédent, « alors » le conséquent. Son utilisation engendre le célèbre paradoxe du Menteur qui a été énoncé par Eubulide de Mégare (IVe siècle a.-C.) : lorsque l'antécédent est vrai, le conséquent est vrai. Cependant, lorsque que l'antécédent est faux, le conséquent peut être vrai puisqu'il s'agit d'une logique formelle : c'est la relation de pertinence. Désormais, on peut définir l'équivalence qui formule par une double vérité conditionnelle : si A alors B et si B alors A ; A et B sont pertinents.

Le Moyen Age établit également quatre types de proposition logique :

A dit Universelle affirmative : tout X est M ;

E dit Universelle négative : aucun X n'est M ;

I dit Particulière affirmative : quelque X est M ;

O dit Particulière négative : quelque X n'est pas M.

En 1931, Kurt Gödel (1906-1978) démontra le théorème d'incomplétude « selon lequel toute théorie mathématique suffisamment riche, contient, lorsqu'elle est cohérente, des énoncés qui y sont indécidables, c'est-à-dire qui ne peuvent y être ni prouvés ni réfutés » (Dubucs et Sandu, 2005, p. 2-5). Ce théorème est fondamental car il nous fait comprendre que la mathématisation et sa logique contiennent des limites. Il « montrait pour la première fois qu'aucun système d'axiomes ne peut à lui seul prouver toutes les vérités mathématiques » (Chaitin, 2006, p. 70-76). Il démonte un mythe scientifique établi par Galilée 300 ans plus tôt ! « On a montré que dans tout système fini d'axiomes, il existe une infinité d'énoncés mathématiques vrais qui ne peuvent y être prouvés » (Chaitin, 2006, p. 70-76). En effet, ce théorème exprime que « la cohérence de n'importe quelle théorie qui contient des nombres entiers ne peut être démontrée de l'intérieur de la théorie elle-même. En d'autres mots, aucune théorie qui prétend fonder la mathématique n'est en mesure de s'auto-justifier mais au contraire elle est contrainte à chercher une justification en dehors d'elle-même. En particulier, aucune théorie de ce genre qui soit cohérente ne peut être complète, au sens de pouvoir démontrer toutes les vérités mathématiques exprimables dans son langage, et l'une des vérités qu'elle ne peut démontrer est précisément sa propre cohérence. Pour cette raison, le résultat de Gödel fut appelé théorème d'incomplétude » (Odifreddi, 2004, p. 48). Par conséquent, « la signification des résultats de la logique mathématique demande une analyse philosophique » (Dubucs, Sandu, 2005, p. 2-5). Autrement dit, si certaines humanités, comme la géographie, mathématisent leur propos, il faut qu'elles prennent conscience de la limite philosophique, et non scientifique, de leur discours mathématisé. Les mathématiques deviennent donc un outil, et non plus une vérité absolue. « Nous sommes maintenant en 2006, 100 ans exactement après la naissance de Gödel (28 avril 1906), et nous ignorons encore l'importance de son résultat d'incomplétude. L'incomplétude des mathématiques doit-elle nous inciter à les pratiquer différemment ? L'avenir nous le dira » (Chaitin, 2006, p. 70-76).

3.1.3.2.2. La problématique

La problématique est « l'intermédiaire entre la logique formelle et la recherche concernant le contenu » (Grawitz, 2001, p. 4). « Elle répond à un besoin de cohérence logique, met en œuvre un ensemble de problèmes qui orientent la recherche et un corps de concepts qui, directement ou indirectement, débouchent sur des hypothèses rendant compte d'un contenu riche de conflits » (Grawitz, 2001, p. 4). Ce qui signifie que « forme et contenu ne peuvent être totalement séparés et la logique, même formelle, garde malgré tout une signification concrète dont la limite imprécise laisse entier le problème essentiel : comment unir la forme et le contenu, passer de l'être passant à l'être existant ? » (Grawitz, 2001, p. 4). C'est le dualisme kantien entre la forme et son contenu ; la pensée et l'objet à connaître (la « chose en soi »).

3.1.3.2.3. Les raisonnements

Le raisonnement déductif est avant tout une démonstration. Le raisonnement déductif part du champ phénoménal pour dégager un champ théorique. Les faits construisent leur propre théorie. Des prémisses supposées entraînent des conséquences déduites qui sont des certitudes comme la mathématique. C'est la conception aristotélicienne.

Le raisonnement inductif recherche la généralisation. Le raisonnement inductif part du champ théorique pour expliquer le champ phénoménal. Le fait observé entre dans un concept existant. Le processus de généralisation est nécessairement une abstraction. Le meilleur exemple est le syllogisme qui comprend trois propositions : la majeure, la mineure et la conclusion. Une erreur amène une contradiction. Il peut être envisagé par trois approches, décrites par Bernard Lepetit (in Revel, 1996, p. 71-94). La première approche est d'utiliser un concept existant pour passer d'un objet singulier à une généralité. La seconde technique, si le concept est imparfait ou inexistant, est d'effectuer un échantillonnage statistique, et le généraliser à toute une population mère. C'est un raisonnement inductif, très largement répandu dans les différentes sciences. La troisième possibilité est d'utiliser la ressemblance entre plusieurs faits, et les généraliser. C'est un raisonnement analogique, peu utilisé à l'heure actuelle parce qu'il a été discrédité par la modernité de Galileo Galilei et de René Descartes.

Le débat entre raisonnement déductif et raisonnement inductif est loin d'être tranché. À la rigueur de la déduction s'oppose la richesse de l'induction. Toutefois, ils peuvent se décliner en d'autres types de raisonnement comme le raisonnement par l'absurde ou l'abduction. Le raisonnement par l'absurde consiste à démontrer un théorème en montrant que des conséquences contradictoires résultent de l'hypothèse contraire. Il essaye de prouver qu'une hypothèse est fausse parce qu'elle ne peut pas entrer dans un champ théorique existant, ni même en établir un.

Le raisonnement dit de l'abduction a été élaboré par Charles Peirce (1839-1914). Il consiste à « remonter » de l'effet à la cause, c'est-à-dire reconstruire les étapes d'un processus à partir du résultat actuel, se distinguant de la déduction qui emprunte un chemin inverse (de la cause vers l'effet).

3.1.3.3. Les concepts.

« Toute science utilise des mots et des concepts » (Aron, 1969, p. 116). Le but de toute science est de construire un objet scientifique, c'est-à-dire un concept, une matière d'étude universelle servant de généralisation. « Le mot ne remplit entièrement sa fonction que s'il a une signification exacte, autrement dit, s'il correspond à un concept » (Aron, 1969, p. 116-117). Un concept est donc une représentation mentale générale et abstraite d'un objet ou d'une idée. Il définit les caractères spécifiques d'un projet, d'un produit, par rapport à l'objectif ciblé. Toutefois, certains concepts sont également sources d'échange entre les différentes disciplines.

Il faut préciser qu'un concept n'est pas le phénomène lui-même. C'est une abstraction, une pensée, un moyen de connaissance. Le concept est, en réalité, double. Il représente une activité pratique, sensible, le contact avec le monde sous la forme des êtres singuliers. Progressivement, son contenu devient une abstraction universelle. Le concept formé va au-delà de l'immédiat sensible, de l'apparence, du phénomène, dans un degré supérieur d'objectivité. « La logique du concept est une logique de l'essence » (Lefebvre, in Grawitz, 2001, p. 18). C'est un outil qui permet de comprendre.

Le concept est plus ou moins étendu, plus ou moins compréhensif. Si l'étendue est grande, le concept est peu compréhensif. Les concepts se créent, s'enrichissent et disparaissent sans que leurs contours obéissent à une délimitation rigoureuse. On reconnaît au concept une valeur de généralité. Sur l'élaboration des concepts, empiristes et rationalistes s'affrontent. Ainsi, Jean-Paul Delahaye (1994) distingue trois catégories de concept. Le concept est dit effectif lorsqu'il définit son contenu par un moyen sans ambiguïté. Le concept constructif se précise au fur et à mesure que les travaux avancent : il est impossible de le définir sans ambiguïté. Le concept prospectif est un discours où rien n'est explicite. C'est un mot issu de la langue courante sans connotation scientifique.

Cependant, il faut distinguer les concepts et les termes correspondants, c'est-à-dire les expressions verbales ou symboliques qui représentent ces concepts. Pour mentionner des termes particuliers et des choses particulières de n'importe quel autre genre, on a besoin de noms ou de désignations. En accord avec une convention classique de la logique et de la philosophie analytique, on forme un nom ou une désignation d'un terme en le mettant entre des guillemets anglais.

D'après Carl Hempel (1996), il existe deux types de définition dans un concept :la définition nominale et la définition réelle. La définition nominale utilise un mot ou une phrase (definiens) comme substitut d'une autre (definiendum). Autrement dit, le concept, dans ce cas, a la signification qui lui est donnée arbitrairement. Le concept ne prétend à d'autre vérité que la conformité à sa propre définition : il n'ajoute rien à nos connaissances, mais peut, sur le plan méthodologique, aider à les accroître. Le risque de cette définition est que celle-ci peut être considérée comme réelle par ceux qui l'emploient. Ladéfinition réelle désigne l'objet par ses caractéristiques essentielles : elle suppose donc une vérité. Elle établit une équivalence entre le défini et la définition. Elle dépasse le plan du langage pour atteindre celui de la connaissance. Il faut remarquer que l'on juge les définitions nominales d'après leur utilité, tandis que les définitions réelles sont jugées d'après leur vérité.

Toutefois, il existe également des définitions dites opératoires. Le concept opératoire de Karl Popper (1902-1994) est la mesure même qui mesure la mesure à mesurer. L'idée centrale de l'opérationnalisme est que la signification de chaque terme scientifique doit pouvoir être déterminée en spécifiant une opération de vérification bien définie qui lui fournit un critère d'application. Elles exigent une cohérence des critères opératoires, mais cela encourage la prolifération de concepts très proches et la multiplication de définitions pour un même terme. Les étalons opératoires peuvent donc avoir un usage dangereux. Il ne faut donc pas isoler une hypothèse sous prétexte qu'elle n'a pas été définie, ce qui signifie que la définition opératoire est de moins en moins utilisée. En effet, il faut admettre que dans ce concept opératoire, Karl Popper exprime clairement sa vision libérale du monde : tout devant être utile et utilisable ou disparaître, vision qui peut être dangereuse. Comment peut-on évaluer, par anticipation, « opérationnabilité » d'un concept ?

Enfin, il faut donner les trois éléments de définition d'un concept scientifique.

Il y a habituellement le choix entre plusieurs critères d'application pour un terme et ceux-ci reposent sur des ensembles différents d'opérations.

Pour comprendre la signification d'un terme scientifique et l'utiliser à bon escient, on doit connaître le rôle qu'il joue dans un système et ce qu'indiquent les principes théoriques dans lesquels il figure et qui le relient à d'autres termes théoriques.

Un terme scientifique ne peut pas être considéré comme « synonyme » d'un ensemble d'opérations, au sens où sa signification serait complètement déterminée par elles.

3.1.3.4. Les théories

Une théorie a pour but d'identifier les causes et les effets entre les faits objectivés. La théorie englobe principes et concepts, ainsi que les modèles. Celle-ci est liée à un courant de pensée appartenant à l'époque qui l'a produite, ce qui signifie qu'une théorie est « mortelle ». On estime qu'elle a une espérance de vie moyenne limitée à une cinquantaine d'années. Il faut confronter le point de vue des rationalistes et des empiristes sur les théories. « Pour un rationaliste, le critère de la vérité ne dépend pas de nos sens : il est intellectuel. » (Grawitz, 2001, p. 16). Les théories sont des constructions logiques, des schémas conceptuels. C'est la conception platonicienne de la théorie. A contrario, « l'empiriste affirme que l'origine de la connaissance se trouve dans l'expérience. Il croit en la valeur de l'observation et en celle de la sensation » (Grawitz, 2001, p. 16). C'est la conception aristotélicienne de la théorie.

Une théorie a trois objectifs :

décrire et montrer ;

expliquer et comprendre ;

prédire et prévoir.

Pour satisfaire à ces objectifs, les théories utilisent les lois qui sont des relations formalisées et mathématiques. Elles transcrivent un fait régulier et récurrent. Par exemple, les lois de la physique relèvent du laboratoire. Les faits observés sont de plus en plus soumis à des expériences éloignées de la réalité. La loi est une propriété de la nature. Cependant, la nature est complexe et la loi est simple. Autrement dit, la loi n'est qu'un moyen, une régularité statistique. Par cette relation répétable le scientifique cherche à construire des objets scientifiques. Il existe deux types de lois : la loi stricte et la loi de l'évolution. « Les entités et les processus fondamentaux postulés par une théorie et les lois supposées les régir doivent être définis avec toute la clarté et la précision souhaitables ; faute de quoi, la théorie ne peut remplir son but scientifique » (Hempel, 1996, p. 110-111). Le problème est qu'il existe des théories qui ne sont pas testables comme la plupart des théories de l'évolution que ce soit celle de Charles Darwin ou celle de Laurent Nottale. Cependant, certaines sont testables de façon probabiliste comme les méthodes Monte Carlo. Quoi qu'il en soit, toute théorie est mortelle. Il suffit de montrer qu'il existe un contre exemple à la loi dégagée pour invalider ou mettre le doute sur la théorie.

Pour conclure, il faut préciser qu'il serait excessif d'exiger qu'une théorie corresponde à la réalité : d'une part, parce que la réalité est inaccessible par nos sens et d'autre part, parce que ce n'est pas l'objectif de la théorie. Elle cherche plutôt à offrir quelques clefs permettant de comprendre le monde dans lequel nous vivons. Autrement dit, la critique classique de l'analyse spatiale, au sein de la géographie, n'a aucun sens. En effet, nombreux sont ceux qui s'indignent sur le fait que l'analyse spatiale s'éloigne de la « réalité », mais cela est parfaitement normale et légitime par rapport son projet.

3.1.3.5. Les modèles

Un modèle consiste en la représentation formelle d'idées ou de connaissances, relatives à un phénomène. Le modèle est beaucoup moins vaste qu'une théorie. Il a justement une vision opérationnelle de la recherche. Tout modèle est un compromis entre une simplicité incomplète et un réalisme reflétant la complexité de la réalité. Le modèle implique la mise en forme de relations entre certains facteurs, c'est-à-dire la sélection de variables et leur mise en place respective. Le modèle est souvent visuel : c'est un assemblage topologique d'éléments.

En géographie, l'utilisation de modèles est de plus en plus fréquente car ils sont un bon compromis entre le champ phénoménal et le champ théorique. Peter Haggett (1973) souligne que le modèle est économique car il permet de transmettre ce qu'il y a de général dans l'information sous une forme très condensée. Le modèle est stimulant, car l'application permet d'en voir les lacunes qui conduisent à de nouvelles recherches, à de nouveaux modèles.

Le modèle scientifique est extrêmement rare car il est totalement décrit, explicité, vérifié, valable de tout temps et en tout lieu. La plupart des modèles sont donc à la fois des outils et des catégories intermédiaires soumis à une évolution de pensée constante. « Comprendre ce qui se passe autour de nous revient en réalité à construire des modèles et à les confronter à nos observations » (Prigogine, Nicolis, 1992, p. 279).

3.1.4. Le champ ontologique

3.1.4.1. Être et objets

Le champ ontologique est une réflexion sur le statut de la réalité. On y réfléchit sur la vérité contenue dans les sciences. Il possède deux entités : l'être et les objets construits. L'être existe de tout temps et en tout lieu. L'objet construit n'existe que par la théorie qui l'a élaboré.

3.1.4.2. Les paradigmes

Les paradigmes sont des « découvertes scientifiques universellement reconnues qui, pour un temps, fournissent à une communauté de chercheurs des problèmes types et des solutions » (Kuhn, 1983, p. 11). Les paradigmes de Thomas Kuhn sont vagues ! Il s'agit d'une acceptation souple et mal définie. En grec, paradigme signifie « exemple ». De plus, qu'est-ce qu'une communauté scientifique ? En vérité, c'est beaucoup de choses. Elle peut recouvrir l'ensemble de la communauté des chercheurs. Cela revient à dire qu'il existe des problèmes types et des solutions types qui mettent tous les chercheurs d'accord. Incontestablement, il s'agit ici d'un synonyme de « cadres doctrinaux » ; c'est dans ce sens que Marc Luyckx-Ghisi (2001) emploie le terme. Cependant, les paradigmes peuvent également, selon la définition de Thomas Kuhn, ne satisfaire qu'une communauté scientifique. Dans ce cas, le sens du terme paradigme devient flou. Est-ce un synonyme de projet disciplinaire ou de théorie ou de concept ? La meilleure réponse est, sans doute, une réponse balancée : « ça dépend du contexte ou de la phrase ». Pour Jacques Leca, le paradigme n'est pas une théorie, mais un ensemble de propositions partagées par un groupe de chercheurs, organisant la façon d'aborder un fait concret, de découper un certain nombre de questions à propos de tel objet, d'élaborer des méthodes d'établissement et d'évaluation des preuves, de formuler des généralisations découlant de ces preuves. Toutefois, le terme « paradigme » est très pratique pour désigner un ensemble de théories, de concepts et un projet disciplinaire puisqu'il désigne les découvertes scientifiquement reconnues pour un temps. Ainsi, un paradigme, au niveau d'une discipline ou d'une sous-discipline, est un agrégat cohérent de théories et de concepts, unis par un projet disciplinaire. Pour ne pas confondre les deux définitions, il faut appeler le paradigme, cadre doctrinal, métaparadigme, et on nommera l'autre paradigme tout simplement.

On observe au XXIe siècle que de nombreuses sciences attaquent de plus en plus les métaparadigmes. Autrement dit, le modèle cartésien, moderne, admis depuis des siècles, n'est plus universel. Certaines disciplines ouvrent de nouvelles possibilités. Pour bien comprendre cette évolution qui passe presque inaperçue en ce début du XXIe siècle, il faut entreprendre un rapide panorama de l'histoire des sciences de l'Antiquité à nos jours, le but étant de montrer l'apparition d'un nouveau métaparadigme.

3.2. Les cadres doctrinaux

Il existe de nombreux cadres doctrinaux (ou métaparadigme). Marc Luyckx-Ghisi (2001) complète la définition du paradigme en lui ajoutant une influence sociétale non négligeable. Il s'agit d'un cadre de pensée dans lequel se trouvent la société et la communauté scientifique. La doctrine scientifique pose la croyance scientifique. Il existe plusieurs doctrines scientifiques. En Occident, trois semblent avoir été mis en œuvre : le paradigme de la pré-modernité, le paradigme de la modernité et le paradigme de la « transmodernité » qui serait en cours de construction autour des sciences de la complexité.

3.2.1. Le paradigme pré-moderne

C'est celui qui va être mis en avant pendant 3000 ans (2500 a.-C. – 1600 p.-C.). L'homogénéité de cette période est contestable, ne serait-ce que par la division traditionnelle de l'Antiquité et du Moyen Age. Certes, le point de rupture n'est pas négligeable : le passage de sociétés polythéistes à des sociétés monothéistes demeure un grand changement dans la conception de la science. Toutefois, comme de nombreux historiens l'ont montré, le passage de l'Antiquité au Moyen Age s'accompagne d'une continuité de la philosophie antique qui s'est adaptée à la chrétienté ou encore à l'islam. Si on prend l'exemple de Platon, il fut interprété par saint Augustin. Aristote, quant à lui, a été interprété, entre autres, par saint Thomas d'Aquin. La coexistence des deux pensées ne fut pas pacifique. Il suffit de rappeler la querelle des Universaux, mais d'un point de vue philosophique et scientifique, on ne peut y voir une rupture nette. Les conceptions antiques demeurent dans les conceptions médiévales, et même celle du début de la Renaissance.

D'après Marc Luyckx-Ghisi, le paradigme pré-moderne aurait d'abord la particularité d'être vertical et autoritaire, patriarcal, intolérant car sa vérité est exclusive. La pré-modernité est opposée à la sécularisation. Cependant, le système symbolique présente l'énorme avantage d'être stable et poétique. Le monde de la magique domine. Le système est enchanté. Il n'existe qu'une seule science : la théologie. La pré-modernité a un sens du sacré évident et non discuté.

3.2.2. Le paradigme moderne et postmoderne

À partir du XVIIe siècle, on manifeste une attention particulière pour les méthodes et les démarches de la pensée, un déplacement d'intérêt de la métaphysique à la théorie de la connaissance. La science dite moderne est fondée sur le rejet de la cause formelle et de la cause finale. Les fondateurs en sont René Descartes et Galileo Galilei. Dans son Discours de la méthode (1637), René Descartes formalise les idées que reprendra Galileo Galilei. Il met en avant les causes efficientes. Autrement dit, il s'agit de rechercher l'origine de l'existence d'un objet : sa raison d'être. Il organise tout travail de recherche autour d'une méthodologie articulée par quatre préceptes constituant sa méthode, devenus classiques aujourd'hui.

René Descartes (1596-1650) est-il un des pères de la modernité ? Le débat reste ouvert. Quoi qu'il en soit, sa méthode est au cœur de la science moderne. Il insiste sur la valeur des mathématiques non pour leur précision quantitatives, mais seulement pour la certitude et l'évidence de leur démarche. « Descartes inaugura un nouveau paradigme numérique, fondé cette fois sur ce qu'aujourd'hui nous appelons analyse, c'est-à-dire les nombres réels. La géométrie devint analytique, et points et entités géométriques furent réduits à des coordonnés et équations : par exemple, les droites à des équations de premier degré » (Odifreddi, 2004, p. 18). Il cherche à prouver la validité de la science. Comment concilier l'univers quantitatif et la perception qualitative ? Qui nous dit que nos représentations s'accordent avec les choses et que le monde est intelligible ? René Descartes pratique le raisonnement expérimental en adoptant un système de raisonnement hypothético-déductif. « Avant Descartes, le hasard seul, ou le génie, permettait de résoudre une question géométrique [(c'est la méthode d'invention)] ; après Descartes, on a pour arriver au résultat des règles infaillibles [(c'est la méthode de résolution)] ; pour être un géomètre il suffit d'être patient » (Poincaré, in Bachelard, 1934, p. 169-170). Il développe une vision mécaniste du monde. Enfin, il faut préciser que, pour lui, la raison s'accorde aux choses parce que toutes deux sont l'œuvre de Dieu. L'évidence est le critère de la vérité. La vérité est dégagée par le sensible. Autrement dit, la base de la science n'est pas expérimentale.

« Le premier était de ne recevoir jamais aucune chose pour vraie que je ne la connusse évidemment être telle, c'est-à-dire d'éviter soigneusement la précipitation et la prévention et ne comprendre rien de plus en mes jugements que ce qui se présenterait si clairement et si distinctement à mon esprit que je n'eusse aucune occasion de le mettre en doute.

« Le second, de diviser chacune des difficultés que j'examinerais en autant de parcelles qu'il se pourrait et qu'il serait requis pour les résoudre.

« Le troisième, de conduire par ordre mes pensées, en commençant par les objets les plus simples et les plus aisés à connaître, pour monter peu à peu comme par degrés jusqu'à la connaissance des plus composés : en supposant même de l'ordre entre ceux qui ne se précèdent point naturellement les uns les autres.

« Et le dernier, de faire partout des dénombrements si entiers et des revues si générales que je fusse assuré de ne rien omettre »(Descartes, éd. 1999, p. 27).

Le premier précepte révèle le premier principe de la modernité proposée par René Descartes : l'évidence. Cela consiste à prétendre qu'un fait peut s'expliquer simplement, d'une manière évidente. Autrement dit, la complexité des êtres et des objets n'est qu'apparente. « Descartes a fondé la méthode d'analyse scientifique en posant que, pour résoudre un problème complexe, il suffit de le séparer en parties plus simples, de décrire ces parties plus simples, puis de les réintégrer pour obtenir une compréhension du tout » (Nottale, 1998, p. 31-32). Ce principe nie également les causes finales et formelles puisqu'il veut « éviter soigneusement la précipitation et la prévention ». C'est donc la victoire de la pensée platonicienne. Cependant, il faut relativiser cette négation de la cause formelle. En effet, la forme existe toujours, mais elle est réduite à une perception phénoménologique. Parfois, elle peut être idéalisée avec un formalisme mathématique. Cela va des formes euclidiennes banales (le cercle, le carré, le triangle) jusqu'à des formes particulières comme les formes fractales.

Le second précepte est le réductionnisme. Il s'agit de partir de l'idée que la complexité du monde n'est qu'apparente, et de le découper en petits problèmes, de manière à aboutir à une chaîne qui mettra en lumière les évidences du premier précepte. Aujourd'hui, le réductionnisme cartésien fait l'objet d'une vigoureuse controverse. Le problème principal du réductionnisme est que « les méthodologies réductionnistes marchent tant que les éléments présentent une individualité bien définie, tant qu'ils présentent des caractères d'immuabilité bien marqués. Quand ils sont plus « flexibles » et qu'ils n'ont pas une individualité très nette, la décomposition du système en éléments ne se révèle plus efficace » (Thom, 1983, p. 85-86). Cependant, pour Laurent Nottale, « la méthode cartésienne a parfois été taxée de réductionnisme. C'est, à mon avis, un faux procès qui procède précisément d'une réduction de la pensée cartésienne. Peut être réductrice, effectivement, une application restreinte de cette méthode à un problème particulier. Mais il est remarquable qu'au cas où un tel blocage de la pensée survienne (ce qui arrive souvent en physique), l'appel au mode de pensée cartésien apporte souvent la solution au problème tout simplement parce qu'il s'agit en fait d'une méthode générale d'analyse des lois de la nature. Par l'exemple, l'idée que le tout soit la somme des parties (exemple d'idées « réductionniste ») ne fait pas explicitement partie du point de vue cartésien. Il s'agit d'analyser le système considéré pour y découvrir des parties plus simples dans leur description, mais l'identification de ces parties peut parfaitement être plus complexe qu'un simple découpage, et la reconstruction du tout plus élaborée qu'un simple collage… » (1998, p. 32). L'argumentation de Laurent Nottale mérite d'êtreretenue mais le propos cartésien a été déformé au cours des siècles, notamment par le positivisme, pour devenir réductionniste. Il l'est toujours aujourd'hui.

Enfin, il faut présenter la pensée de Gaston Bachelard (1934). « La méthode cartésienne est réductive, elle n'est point inductive. Une telle réduction fausse l'analyse et entrave le développement extensif de la pensée objective. Or il n'y a pas de pensée objective, pas d'objectivation, sans cette extension. […] La méthode cartésienne qui réussit si bien à expliquer le Monde, n'arrive pas à compliquer l'expérience, ce qui est la vraie fonction de la recherche objective » (Bachelard, 1934, p. 142). Gaston Bachelard critique René Descartes pour sa recherche des natures simples et absolues. Il admet que dans certain cas la méthode dite cartésienne est suffisante. « Pour les savants du XIXe siècle aussi bien que pour Descartes, les bases rationnelles du mécanisme étaient inébranlables » (Bachelard, 1934, p. 186). Cependant, il note un certain abus dans les explications scientifiques de cette méthode.

Le troisième précepte est la mise en avant de la causalité efficiente. Celle-ci est fondée sur la continuité de la chaîne produite par le processus. Elle ne peut donc pas être lacunaire. Elle est pensée sur le modèle de la linéarité, puisqu'une petite cause génère un petit effet et qu'une grande cause produira un grand effet. C'est le fameux rationalisme d'Aristote. Il suffit donc de remonter la chaîne des évidences pour expliquer la complexité du monde. En revanche, il ne faut pas confondre causalité et déterminisme. Une causalité peut être qualitative et/ou quantitative alors que le déterminisme ne concerne que le quantitatif. Ainsi lorsque les humanités prétendent qu'elles ne sont pas déterministes, elles n'expriment qu'une tautologie puisque la plupart d'entre elles ne sont que qualitatives2. Cependant, aujourd'hui, dans un système complexe, la causalité change de statut : elle devient indéterminable. On ne peut jamais prouver qu'un phénomène a été provoqué par telle ou telle cause, ou plus exactement la cause ultime qui sera amplifiée par la non linéarité du système ne peut être identifiée. Comment identifier la vibration d'un atome qui déclenche un tremblement de terre ou une avalanche ?

Le quatrième précepte correspond au principe d'exhaustivité. Il est basé sur le fait que l'information scientifique est nécessairement infinie, et qu'il faut la recenser le plus précisément possible. La conséquence de ce principe est qu'il y a toujours quelque chose à découvrir. Cependant, il semblerait que les sciences aient aujourd'hui atteint une limite. En effet, le rythme des découvertes majeures en physique, par exemple, tant dans le champ phénoménal et dans le champ théorique, a fortement ralenti depuis le milieu du XIXe siècle. De plus, nombreux sont les scientifiques qui croient que ce principe est un mythe. C'est sans doute pour cela qu'ils ont mis l'accent sur le second principe de René Descartes. Enfin, l'exhaustivité de la mesure a provoqué une « inflation » de l'information.

Galileo Galilei, père de la modernité, a associé la chute libre d'un corps à la variable temps. Cette équation a permis une mise en avant de la cause efficiente d'Aristote puisqu'elle dissocie pour la première fois dans l'histoire des sciences, temps et espace. La cause efficiente est également liée aux forces présentes dans l'univers. Les causes finales et formelles n'existent plus. Quant à la cause matérielle, elle est maintenue, parce que la nier serait nier l'existence des objets d'étude, c'est-à-dire le fondement des sciences. Galileo Galilei éprouve la méthode de René Descartes en quelque sorte.

Cette construction scientifique s'est bâtie de concert, avec ce qu'il est commun d'appeler, la société moderne. La science y tient une place éminente. La modernité a développé ainsi son propre modèle social, qui est globalement toujours en place aujourd'hui. D'après Marc Luyckx-Ghisi (2001), il consiste à partager la vie des individus en deux : une vie appartenant au domaine privé, une autre appartenant au domaine public. La vie publique est un système social hiérarchique dont on peut considérer qu'il est dominé par les tenants du pouvoir scientifique tout autant que par les tenants du pouvoir politique, les élus. La vie privée est un autre monde où se meuvent d'autres dimensions de la vie sociale. C'est de ce côté qu'une partie des causes aristotéliciennes et des entités matérielles ou immatérielles comme la forme se retrouvent de facto. Dans le domaine public, au sommet de la pyramide se trouve la raison, il s'agit bien sûr d'une dimension en rapport étroit avec les causes efficientes. Ensuite, viennent ceux qui sont capables de décoder ces causes : d'abord les scientifiques, ensuite les politiciens qui appliquent les progrès dégagés par les scientifiques ; enfin, le reste de la société où l'homme est nettement supérieur à la femme. Dans une vision moderne, les causes finales et formelles relèvent donc de questions métaphysiques entrant dans le champ de la philosophie et de la littérature. Elles recouvrent des faits qui ne sont pas scientifiquement objectivables. Ce paradigme de la modernité offre une autre solution au problème philosophique de la liberté de l'homme puisque, désormais, il possède un espace de libertés : son domaine privé, et un espace de contraintes : le domaine public. Grâce à cela, on met en avant le progrès scientifique. Ainsi l'espace de contraintes devient utilitaire au libre-arbitre humain. Dans cette position, on comprend l'intérêt scientifique et philosophique de l'histoire. Elle permet d'être au cœur de la liberté humaine en formulant son propos de la manière suivante : hier, on en était là, aujourd'hui, on en est là, et demain, on en sera sûrement là. Cette liberté est fondée sur l'idée que l'homme est, par nature, bon, ce qui reste en soi à démontrer. Toutefois, la raison placée au sommet de la pyramide a posé problème. L'utilisation du terme renvoie à une vérité absolue qui, en soi, n'existe pas.

Ce schéma moderne rencontre aujourd'hui des difficultés. Pour les résoudre, l'astuce trouvée a été, dans le schéma postmoderne, de remplacer la raison par l'idée qu'il n'existait pas une vérité, ce qui pose d'autres problèmes. En effet, cela met sur un même pied d'égalité un astrophysicien avec un astrologue, par exemple… Par ailleurs, les progrès de la science et de la technologie produisent de plus en plus des inquiétudes plus ou moins raisonnables (OGM, réchauffement climatique, déchets nucléaires, etc.). La postmodernité est fondée sur un scepticisme. Toutefois, ce début d'évolution du paradigme de la modernité semble indiquer que la modernité entre en crise à la fin du XXe et se poursuit en ce début du XXIe siècle.

3.2.3. Le paradigme transmoderne

La vision de la recherche formulée par la modernité a été contestée par l'approche systémique mise en place depuis une cinquantaine d'années. Objectivement, le paradigme transmoderne n'existe pas. Ce n'est qu'une appellation pratique donnée par Marc Luyckx-Ghisi (2001). Personnellement, ce terme me semble plus approprier que « paradigme de la complexité ou du chaos » qui est plutôt réducteur, mais plus fréquent dans la littérature. Il a été, en quelque sorte, annoncé par Gaston Bachelard dans le chapitre 6 intitulé « l'épistémologie non cartésienne » du Nouvel esprit scientifique (1934). Cependant, la découverte de la complexité commence par l'élaboration de la théorie des systèmes dans les années 1950.

Un système est un ensemble cohérent d'éléments interdépendants et non hiérarchisés. La systémique est l'étude d'un rapport entre le système et son environnement, d'une organisation, d'une structure et de son fonctionnement, et d'une dynamique propre au système. Cette approche possède, comme l'approche cartésienne, quatre préceptes : la pertinence qui est le rapport entre l'objet d'étude et le chercheur, « qu'est-ce que cette étude va lui apporter ? », la globalité qui considère que le tout du système l'emporte sur la somme des éléments qui le composent, la téléologie qui cherche à établir le comportement du système : on considère le système comme un être vivant, et l'agrégativité qui essaye de représenter de manière simplifiée les éléments connus du système.

La systémique articule ces préceptes autour de deux notions fondamentales : l'interrelation et la totalité. Il s'agit d'avoir, en quelque sorte, une approche holistique du monde, c'est-à-dire l'art de la synthèse expliquant la globalité. Elle propose une méthode qui serait à l'opposé des préceptes de René Descartes. Il n'y a plus de réductionnisme, plus d'évidence, plus de causalité linéaire et continue et plus de recherche de l'exhaustivité des données (fig. 4).

Les préceptes de l'approche cartésienne | Les préceptes de l'approche systémique |

|---|---|

évidence | pertinence (par rapport au problème) |

réductionniste (priorité à l'analyse) | globaliste ou holiste |

causalité (raisonnement linéaire) | |

exhaustivité | agrégativité |

La systémique réintroduit le raisonnement analogique qui avait perdu de son importance avec l'approche cartésienne, puisqu'il est fondé sur la comparaison de différentes formes. Il est vrai que l'analogie peut prendre un aspect très simple et parfois erroné. Toutefois, avec le développement de la systémique, l'analogie peut s'avérer beaucoup plus complexe. Il y en a trois types : les métaphores, les isomorphismes et les modèles. Les métaphores sont des comparaisons entre différents éléments dont le processus de fabrication est identique. Les isomorphismes travaillent sur une analogie structurale. Les modèles sont des représentations abstraites de réalités concrètes. Ils représentent la forme la plus élaborée de l'analogie. À cela, il pourrait être ajouté l'homologie, l'identité des structures comme telles identifiée par des lois de décroissance ou de croissance exponentielle. Grâce au raisonnement analogique et homologique, on peut entreprendre des recherches interdisciplinaires, nécessaires aujourd'hui pour créer des ponts entre les différentes disciplines académiques, ce qui permettra d'élaborer une méthodologie générale pour traiter les objets d'étude appartenant à plusieurs disciplines.

La systémique propose une recherche opérationnelle c'est-à-dire qu'elle se veut finalisée. Elle se fait par étapes successives. La première étape consiste à définir le système et son environnement avec ses entrées et ses sorties. La seconde étape doit montrer ou expliquer l'organisation du système. Cette étape est double : il s'agit de rechercher un état, c'est-à-dire une structure, et un processus, c'est-à-dire un ensemble de fonctions. Pour les établir, il faut chercher la frontière (ou la limite) entre le système et son environnement, puis définir les éléments qui composent le système, ensuite étudier les connexions entre les différents éléments, c'est-à-dire les réseaux, et enfin, trouver ce qui peut servir de réservoir au système. Une fois ce squelette mis en place, il faut chercher les flux, le ou les centres de décisions, les boucles de rétroaction et les délais de réponse. L'établissement de la structure et du processus conduit à définir des lois qui commandent le système, et à comprendre les relations internes et externes du système. À l'intérieur, l'état, c'est-à-dire la structure, correspond à un organigramme qui établit ce que l'on appelle les modules (ou sous-systèmes) en même temps que leur niveau (ou hiérarchie). L'état défini, il faut trouver le mécanisme de fonctionnement : le processus qui gère les différents éléments du système ainsi que les différentes relations entre les niveaux. Ce processus est un programme qui maintient la structure du système. Cependant, il faut remarquer qu'à l'extérieur du système, un certain degré de fermeture existe toujours. Il permet de maintenir l'identité propre du système considéré.

La structure et les fonctions du système comprises, on peut passer à la troisième étape qui consiste à rechercher la dynamique du système étudié. Il en existe essentiellement deux. Un état stationnaire correspond à un système qui s'adapte dans toutes les situations difficiles qui se présentent à lui. Lorsqu'on l'observe, il donne l'illusion d'être immobile, d'être en équilibre. Celui-ci est obtenu par une régulation qui s'appelle l'homéostasie. Elle repose sur la capacité d'un système à produire ce que l'on appelle de la variété, c'est-à-dire le nombre de configurations, ou d'états, que ce système peut revêtir. « L'un des problèmes cruciaux avec ces phénomènes de contrôle est la robustesse : jusqu'où un système peut-il résister à de petits chocs ? » (Gleick, 1991, p. 337 et p. 372). Toutefois, trop de variétés peut conduire à une crise de la structure et des fonctions du système, et engendrer la deuxième dynamique possible : celle de l'émergence. L'émergence est une « apparition inattendue et soudaine (dans une série d'événement ou d'idées) » (Mayet, 2005, p. 5). Elle se produit lorsque le système ne peut plus être plus régulé. Deux cas sont possibles : soit le système redéfinit brusquement sa structure et ses fonctions, soit il est englobé dans un autre système, devenant ainsi un sous-système. L'émergence peut être soit spontanée, c'est-à-dire à partir de rien, soit évolutive, c'est-à-dire à partir d'une accumulation des tensions menant à une agrégation. Cependant, « l'émergence est considérée comme importante, mais sans qu'on sache souvent ce qu'elle est ! » (Sober, 2005, p. 10-13). Quoi qu'il en soit, l'émergence conduit à l'apparition d'un nouveau système qui n'a plus rien à voir avec l'ancien. L'émergence rappelle que le réel n'est pas homogène. Le réductionnisme pose la règle d'addition : le tout est égal à la somme des parties, tandis que l'émergentisme pose la règle d'interaction : le tout est supérieur à la somme des parties.